Widoczność Twojej strony w wynikach wyszukiwania Google zależy od wielu czynników, a jednym z kluczowych jest poprawne crawlowanie Googlebota. Na przykład, badania pokazują, że ponad 75% stron niezindeksowanych miało błędy w pliku robots.txt lub brak mapy strony XML. Bez skutecznego crawlowania, Twoja witryna może pozostać niezauważona przez wyszukiwarkę, co negatywnie wpływa na jej pozycję i ruch. Dowiedz się, czym jest crawlowanie, jak działa Googlebot i jakie narzędzia możesz wykorzystać, aby zoptymalizować proces indeksacji.

Crawlowanie Googlebota – Spis treści:

Co to jest crawlowanie i dlaczego jest ważne?

Crawlowanie to proces, w którym roboty wyszukiwarek, takie jak Googlebot, przeszukują strony internetowe, zbierają dane o ich zawartości i przygotowują je do indeksacji. Indeksacja to z kolei etap, w którym najprościej mówiąc, dane z Twojej strony są dodawane do bazy wyszukiwarki, co umożliwia ich wyświetlenie w wynikach wyszukiwania.

Jeśli Twoja strona nie zostanie poprawnie zweryfikowana, nie trafi do indeksu Google, a potencjalni użytkownicy nie będą mogli jej znaleźć. Dlatego warto zadbać o to, by Googlebot łatwo dotarł do wszystkich istotnych treści na Twojej witrynie.

Crawlowanie Googlebota – co warto wiedzieć na początek

Googlebot to „specjalistyczny program” (tzw. web crawler) odpowiedzialny za analizowanie stron internetowych. Obsługuje zarówno statyczne, jak i dynamiczne treści, co oznacza, że potrafi zrozumieć nawet strony generowane za pomocą JavaScript, jeśli zostały odpowiednio zoptymalizowane. Działa zgodnie z harmonogramem ustalonym przez Google, przeszukując zawartość stron i łącząc dane z linków prowadzących do innych podstron. Aby proces crawlowania przez Googlebota przebiegał sprawnie, warto zadbać o następujące aspekty:

- Struktura witryny: Upewnij się, że Twoja strona ma przejrzystą hierarchię i logicznie rozmieszczone linki wewnętrzne.

- Mapa strony (sitemap): Plik XML zawierający informacje o wszystkich podstronach, które chcesz, aby zostały zindeksowane.

- Plik robots.txt: W tym pliku możesz określić, które części witryny mają być crawlowane, a które nie.

- Szybkość ładowania: Im szybsza strona, tym łatwiej Googlebot może ją przeszukać.

Jak sprawdzić, czy Googlebot crawluje Twoją stronę?

Aby upewnić się, że Twoja witryna jest poprawnie crawlowana, możesz skorzystać z kilku narzędzi SEO, takich jak:

- Google Search Console (GSC): To podstawowe narzędzie, które pozwala monitorować indeksację Twojej strony. W sekcji „Stan” zobaczysz informacje o zindeksowanych stronach, a w sekcji „Pokrycie” znajdziesz dane o problemach z crawlowaniem.

- Logi serwera: Analiza logów pozwala sprawdzić, jak często Googlebot odwiedza Twoją stronę i jakie zasoby przeszukuje.

- PageSpeed Insights: Narzędzie Google, które wskazuje, czy czas ładowania strony może wpływać na crawlowanie.

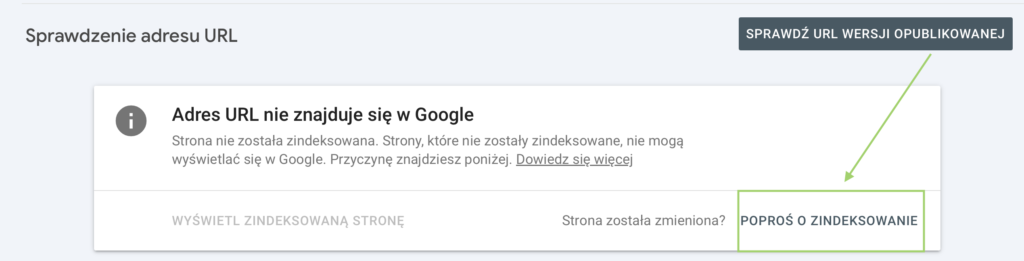

Poniżej przedstawiam prostą i najbardziej skuteczną formę indeksacji URL w wyszukiwarce Google:

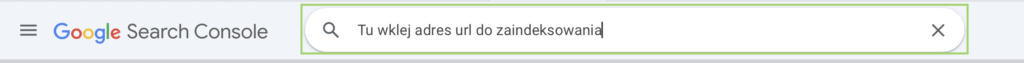

1. Logowanie do Google Search Console – Zaloguj się na swoje konto GSC, które jest połączone z Twoją witryną. <link>

2. Prześlij adres URL – W górnym pasku wyszukiwania wklej adres URL nowej strony, który chcesz zindeksować.

3. Poproś o zindeksowanie – Po sprawdzeniu URL przez Google, kliknij w przycisk „Poproś o zindeksowanie”.

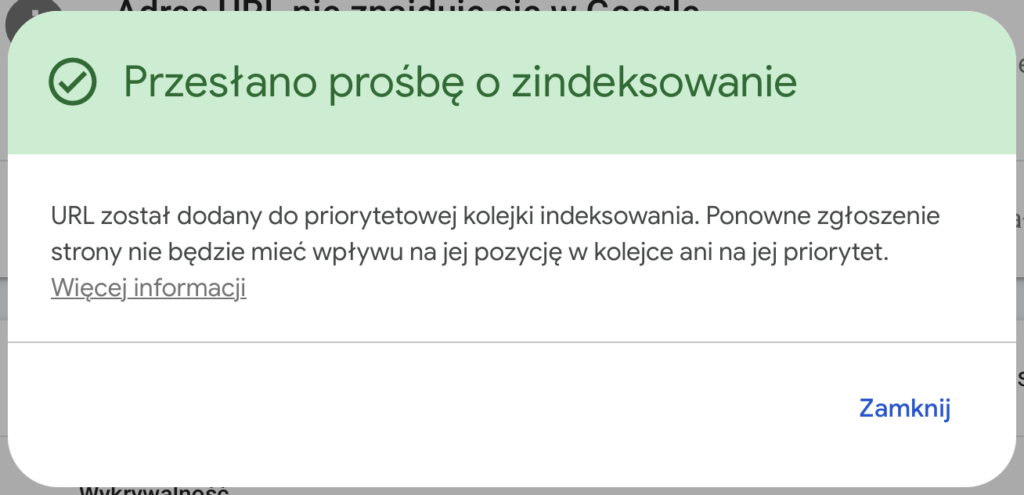

4. Gotowe! – Teraz Google zajmie się zindeksowaniem Twojej strony. Proces może zająć od kilku godzin do kilku dni.

To szybkie i efektywne rozwiązanie na dodanie nowych treści do indeksu Google!

Proces indeksacji może zająć od kilku godzin do kilku dni, w zależności od aktualnego obciążenia serwerów Google oraz jakości i zgodności Twojej strony z wytycznymi Google. Jeśli indeksacja nie nastąpi w krótkim czasie, warto sprawdzić poprawność konfiguracji witryny i upewnić się, że strona spełnia wymagania techniczne.

Potrzebujesz pomocy? skontaktuj się z nami 🙂

Jak poprawić crawlowanie Googlebota na Twojej stronie?

- Optymalizuj strukturę linków wewnętrznych.

- Każda podstrona powinna być osiągalna w maksymalnie trzech kliknięciach od strony głównej.

- Unikaj linków prowadących do stron z błędami 404.

- Zaktualizuj plik sitemap.xml.

- Dodaj wszystkie kluczowe podstrony i upewnij się, że plik jest poprawnie wgrany na serwer. Możesz zgłosić go w Google Search Console.

- Przeanalizuj plik robots.txt.

- Sprawdź, czy nie blokujesz dostępu Googlebota do ważnych zasobów.

- Zadbaj o responsywność strony.

- Strony dostosowane do urządzeń mobilnych są szybciej crawlowane i lepiej indeksowane.

- Regularnie aktualizuj treści, takie jak blogi, opisy produktów czy strony informacyjne. Przykładowo, dodawanie artykułów z aktualnymi trendami w branży może zwiększyć częstotliwość odwiedzin Googlebota.

- Googlebot częściej odwiedza strony, na których pojawia się nowa zawartość. Dodawaj wpisy blogowe, artykuły lub aktualizuj istniejące treści.

Jak zoptymalizować plik robots.txt dla lepszego crawlowania?

Plik robots.txt to kluczowy element, który może wpływać na to, jak Googlebot przeszukuje Twoją witrynę. Oto kilka praktycznych wskazówek, jak zoptymalizować ten plik:

- Unikaj blokowania ważnych zasobów. Sprawdź, czy plik robots.txt nie blokuje dostępu do kluczowych podstron, takich jak pliki CSS czy JavaScript, które są niezbędne do prawidłowego renderowania strony.

- Wykorzystaj dyrektywę Allow i Disallow. Użyj Disallow, aby wykluczyć strony techniczne, takie jak /wp-admin/ w przypadku WordPressa, i Allow, aby zezwolić na crawlowanie ważnych elementów.

- Dodaj link do mapy strony. Na końcu pliku robots.txt warto dodać odwołanie do sitemap.xml, co ułatwia Googlebotowi odnalezienie wszystkich podstron witryny.

- Regularnie testuj plik. W Google Search Console znajdziesz narzędzie do testowania robots.txt, które pomoże Ci sprawdzić, czy konfiguracja jest prawidłowa.

- Unikaj pustego pliku. Jeśli nie chcesz blokować niczego, wypełnij plik robots.txt prostą komendą „User-agent: * Disallow:”, co pozwoli na crawlowanie całej strony.

Optymalizacja tego pliku to nie tylko lepsze crawlowanie, ale także wyeliminowanie ryzyka przypadkowego wykluczenia istotnych zasobów. Pamiętaj, że plik robots.txt jest publicznie dostępny, dlatego nie umieszczaj w nim wrażliwych informacji.

Czego unikać podczas crawlowania Googlebota? Jakie problemy najczęściej występują?

- Duplicate content: Powtarzająca się treść w obrębie strony może powodować problemy z indeksacją.

- Nadmierne przekierowania: Zbyt wiele przekierowań może wpływać negatywnie na crawlowanie.

- Brak optymalizacji obrazów: Ciężkie pliki graficzne wydłużają czas ładowania strony.

- Infinite scroll: Strony z nieskończonym przewijaniem mogą uniemożliwiać poprawne crawlowanie.

Jakie znaczenie ma crawlowanie dla szybkości indeksacji nowych treści?

Nowe treści, takie jak wpisy blogowe na stronie internetowej lub produkty w sklepie internetowym, mogą być szybciej indeksowane, jeśli witryna jest regularnie odwiedzana przez Googlebota. Utrzymywanie aktywnego bloga lub systematyczna aktualizacja katalogu produktów to sposoby na częstsze crawlowanie. Pamiętaj, że nawet zmiany w meta tagach mogą przyciągnąć uwagę robota wyszukiwarki, jednak kluczowe jest nie tylko skuteczne crawl-owanie, ale także poprawne renderowanie strony – to ono decyduje, czy Googlebot prawidłowo odczyta i zrozumie jej zawartość.

Chcesz się dowiedzieć więcej na temat crawl-owania i renderowania pod kątem SEO – zapraszamy do naszego artykułu

FAQ – najczęściej zadawane pytania dotyczące crawlowania i indeksacji

1. Jak sprawdzić, czy moja strona jest indeksowana przez Google? Użyj operatora „site:” w wyszukiwarce Google (np. site:twojadomena.pl). Zobaczysz listę zindeksowanych stron.

2. Czy wszystkie strony na mojej witrynie powinny być crawlowane? Nie, warto wykluczyć strony techniczne lub o niskiej wartości, takie jak koszyk zakupów czy strony z polityką prywatności.

3. Jak często Googlebot odwiedza moą stronę? To zależy od popularności Twojej strony i częstotliwości aktualizacji treści. Informacje o wizytach znajdziesz np. w logach serwera.

4. Czy mogę przyspieszyć crawlowanie nowej strony? Tak, możesz zgłosić nową stronę w Google Search Console, korzystając z opcji „Poproś o zindeksowanie”.

5. Czy crawlowanie zależy od mojego hostingu? Tak, hosting o niskiej wydajności może spowalniać crawlowanie. Zainwestuj w szybki serwer, by poprawić wydajność strony.

Crawlowanie Googlebota – podsumowanie

Crawlowanie Googlebota to fundament technicznego SEO, co w dużym stopniu przekłada się na skuteczne pozycjonowanie Twojej strony internetowej. Zrozumienie tego procesu i jego optymalizacja może znacząco wpłynąć na widoczność witryny w wyszukiwarce. Pamiętaj o używaniu narzędzi takich jak Google Search Console, dbaj o jakość treści i regularnie monitoruj stan swojej strony. Wprowadzenie tych praktyk pozwoli Ci maksymalnie wykorzystać potencjał crawlowania i osiągnąć lepsze wyniki w SEO.